Neue Hardware lockt mit gesteigerter Leistung, besseren Features und beeindruckenden technischen Daten, aber bedeuten diese Fortschritte automatisch echten Mehrwert? Wer heute über ein System-Upgrade nachdenkt, sieht sich mit einer Vielzahl an Optionen und teils widersprüchlichen Signalen konfrontiert, wie steigendem Stromverbrauch, spezialisierten Chips und komplexen Zusammenhängen zwischen den Komponenten.

In diesem Artikel beleuchten wir, warum technische Innovationen nicht immer sofort sichtbar sind, welche Trends die Hardware-Entwicklung künftig bestimmen werden und worauf es bei der Entscheidung für oder gegen ein Upgrade wirklich ankommt.

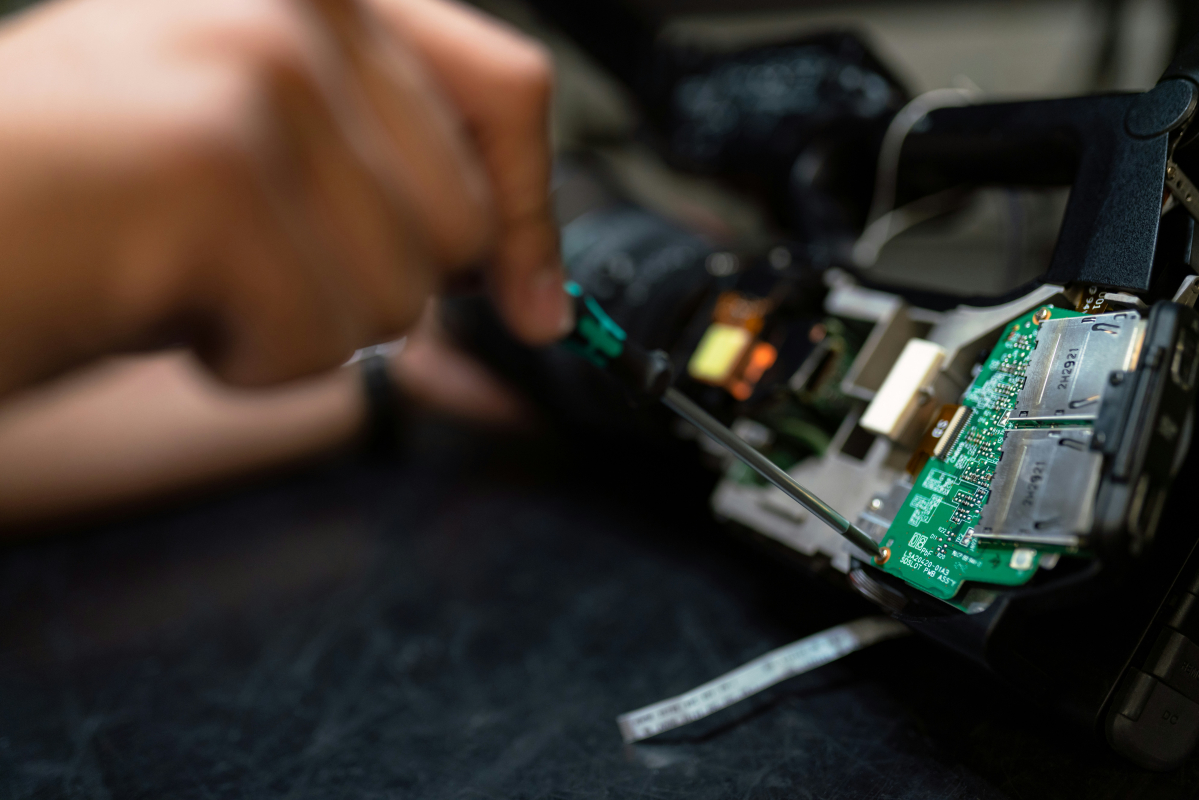

Woran erkennt man eigentlich, ob neue Hardware eine echte Verbesserung bringt? (Bildquelle: unsplash.com)

Woran erkennt man eigentlich, ob neue Hardware eine echte Verbesserung bringt? In Zeiten von Moores Law war das noch einfach, alle zwei Jahre verdoppelte sich die Anzahl Transistoren pro Fläche und damit die Rechenleistung. Doch dieses Tempo gehört längst der Vergangenheit an. Statt immer kleineren Transistoren stehen heute spezialisierte Chips im Fokus, die für bestimmte Zwecke wie Gaming oder künstliche Intelligenz entwickelt werden. Der klassische Fortschritt über generelle Leistungssteigerung gerät ins Hintertreffen.

Das sorgt für Unsicherheit bei Nutzern und Investoren. Viele fragen sich, wann ein Upgrade tatsächlich Sinn ergibt. Schließlich ist mehr Leistung allein kein Garant für besseren Nutzen, wenn die vorhandene Software davon kaum profitiert. Wer heute Investitionen in neue Bauteile plant, muss genauer hinschauen. Häufig lohnt es sich mehr, gezielt einzelne Komponenten zu optimieren, anstatt das gesamte System auszutauschen. Der Trend geht also klar in Richtung effizienter Feinanpassung statt blindem Leistungspush.

Nicht alles, was sich technisch weiterentwickelt, wird auch sofort als Fortschritt erkannt. Viele Verbesserungen laufen heute im Hintergrund ab, etwa durch Software, neue Protokolle oder effizientere Abstimmungen zwischen Systemkomponenten. Das zeigt sich zum Beispiel bei aktuellen Routern, die mit Wi-Fi 7, ZigBee und integrierten VPN-Funktionen ausgestattet sind. Obwohl die neue Routergeneration ihren Vorgängern technisch deutlich überlegen ist, sehen Nutzer davon im Alltag kaum etwas.

Gerade im Bereich digitaler Unterhaltung fällt das besonders auf. Einst sorgte etwa das erste Online-Casino für eine echte Zeitenwende. Heute wirken neue Features wie Live-Dealer, Gamification oder optimierte Menüs eher wie Detailverbesserungen.

Der Begriff Innovation wird im Online-Glücksspiel schnell bemüht, aber neue Features wie Live-Dealer oder Gamification wirken oft weniger bahnbrechend als erwartet. Dort haben beste Casinos ohne Verifizierung mehr Effekt auf die Nutzer und ziehen mehr Spieler an, als es Neuerungen auf technischer Seite könnten. Ähnlich wie bei der Miniaturisierung der Chips werden an dieser Stelle die Grenzen des bereits entwickelten deutlich.

Auch in Streaming-Diensten, Online-Shops oder Smart-Home-Systemen schreiten die Weiterentwicklungen kontinuierlich voran, werden aber selten als echte Neuerungen wahrgenommen. Technischer Fortschritt bleibt vorhanden, doch seine Wirkung verliert an Sichtbarkeit. Was früher als Innovation gefeiert wurde, verkommt heute schnell zum stillen Update im Hintergrund.

Kleiner geht nicht mehr, zumindest nicht ohne Nebenwirkungen. Die Miniaturisierung von Transistoren stößt mittlerweile an physikalische und thermische Limite und damit steigen auch die Anforderungen bei der Architekturplanung von Chips. Denn je kompakter und leistungsstärker moderne Komponenten werden sollen, desto größer wird der Aufwand bei Fertigungstechnologien, Kühlung und Energieeffizienz.

KI-gestützte Entwicklung bringt zwar neue Geschwindigkeit in den Designprozess, besonders bei der Simulation komplexer Strukturen, doch selbst diese modernen Tools haben ihre Grenzen, wenn etwa SSDs mit PCIe-5.0 oder aktuelle GPUs im Zusammenspiel perfekt abgestimmt sein müssen. Ohne datenintensive Anwendungen zeigen solche Komponenten ihr volles Potenzial kaum. Auch Netzteile geraten zunehmend in den Fokus, denn sie müssen nicht nur mehr Leistung liefern, sondern dabei auch leise und effizient bleiben.

Welche Upgrades sich wirklich lohnen, hängt stark davon ab, welche wichtige Komponenten das System tragen. Nur weil etwas neuer ist, bedeutet das nicht automatisch spürbar mehr Performance. So zeigt sich auch bei verschiedenen DDR5-Konfigurationen, dass Optimierungserfolge stark vom Einsatzzweck abhängen und dass klassische Skalierung alleine nicht mehr ausreicht.

Wer sich aktuelle High-End-CPUs anschaut, merkt schnell, dass die Performance steigt, aber auch der Strombedarf spürbar zulegt. Besonders im Gaming wird das deutlich, wie etwa beim Ryzen 7 9800X3D. Dank seines 3D V-Cache erreicht er zwar bemerkenswerte Bildraten, büßt aber bei der Energieeffizienz kräftig ein.

Ein Gegenmodell liefert Intel mit dem Core i5-13600K. Diese CPU kommt in vielen Spielen fast an die Performance eines i9-13900K heran, benötigt dafür aber weniger Energie und bleibt auch bei der Temperaturentwicklung deutlich cooler. Für viele Anwender bringt das die ideale Balance aus Leistung und Effizienz. Entscheidend ist heute mehr denn je das Zusammenspiel aus Architektur, Kühlung und Software. Nur wenn diese Faktoren stimmen, lässt sich im Gaming-Betrieb wirklich das Optimum aus moderner Hardware herausholen.

Abseits bekannter Upgrade-Zyklen entstehen Technologien, die das Fundament künftiger Hardware definieren könnten. Quantencomputing zählt dazu, stellt aber klassische Designs vor ernste Herausforderungen. Der instabile Zustand der Qubits, hohe Kühlanforderungen und eine völlig andere Logik beim Rechnen brauchen neue Denkansätze in der Schaltkreisentwicklung.

In der Praxis setzen Entwickler vermehrt auf spezialisierte KI-Chips, die herkömmliche CPU-Cluster in vielen Bereichen bereits ablösen. Besonders ihre Matrixarchitektur ermöglicht hohe Rechenleistungen bei gleichzeitig sinkendem Energieverbrauch und das ist ein Vorteil, der sich im Betrieb großer Rechenzentren direkt bemerkbar macht.

Auch Neuro-Interfaces rücken in den Fokus. Wenn Sensorik und Signalverarbeitung weiter verfeinert werden, könnten bidirektionale Gehirn-Computer-Schnittstellen bis 2030 ein wichtiger Faktor in der digitalen Wissensarbeit werden. Parallel wächst mit dem sogenannten Space Computing ein eigenes Segment, das auf kompakte, extrem widerstandsfähige Hardware setzt, quasi für autonome Systeme unter extremen Bedingungen.

Beim Thema Sicherheit gelten physisch unklonbare Funktionen als vielversprechende Lösung für die Post-Quanten-Kryptografie. Damit daraus eine zuverlässige Schutzlösung wird, müssen Software, Hardware und Sicherheitsarchitektur optimal zusammenspielen. Auch bei kommenden Grafikkarten spielen solche Konzepte zunehmend eine Rolle, etwa wenn neue Fertigungsverfahren oder KI-basierte Features in die Architektur einfließen.

Viele setzen bei neuer Hardware noch auf den schnellen Wow-Effekt, doch aus technischer Sicht lohnt es sich, Systeme verstärkt auf Nachhaltigkeit und Langlebigkeit auszurichten. Der Fokus verschiebt sich von reinen Performance-Gewinnen hin zu durchdachten Konzepten wie Upgradefähigkeit, Standardisierung und modularer Bauweise. Wer beim Zusammenstellen seiner Komponenten auf nachrüstbare Elemente achtet, sorgt nicht nur für ein flexibleres System, sondern spart auch Ressourcen.

Auch aus Nutzersicht zählen heute andere Kriterien. Energieeffizienz, Kompatibilität und möglichst geringe Lebenszykluskosten rücken bei der Auswahl stärker in den Vordergrund als die nächste Prozessorgeneration oder Marketing-Zahlen. Statt alles neu zu kaufen, wird lieber gezielt erweitert oder angepasst. Dadurch behalten gut strukturierte PCs länger ihre Einsatzfähigkeit, was ein klarer Pluspunkt beim Umgang mit immer selteneren Innovationssprüngen ist.

Wer auf modulare Systeme mit hoher Haltbarkeit setzt, schafft nicht nur mehr technische Stabilität, sondern auch die Freiheit zur späteren Individualisierung. Diese Herangehensweise unterstützt eine neue Innovationskultur, in der nicht mehr allein der Startschuss zählt, sondern die Ausdauer des gesamten Systems.

Im zurückliegenden Monat gab es wieder einige spannende Themen im Bereich Newsmeldungen sowie interessante Artikel und Produkttests. Folgend möchten wir...

Mit der SanDisk Professional G-RAID PROJECT 2 positioniert SanDisk ein 2-Bay-Desktop-RAID für professionelle Medien- und Produktionsumgebungen. Das System ist mit...

Ein vernetztes Zuhause galt kürzlich noch als Spielerei. Smarte Thermostate, Sprachsteuerung und automatisierte Rollläden sind heute in vielen Haushalten üblich....

SanDisk kündigt die nächste Generation seines externen SSD-Portfolios an und stellt eine neu entwickelte dreistufige Produktreihe vor. Das Portfolio umfasst...

Künstliche Intelligenz revolutioniert gerade die Videoüberwachung und erschließt ihr ganz neue Anwendungsbereiche. In der Fertigung lassen sich KI-basierte Videoanalysen beispielsweise...

Das G-RAID PROJECT 2 ist ein 2-Bay Storage-System für Profis und bietet eine Thunderbolt-Schnittstelle inkl. hoher Speicherkapazitäten. Wir haben das 48-TB-Modell getestet.

Mit dem ZOWIE XL2586X+ hat BenQ einen extravaganten Gaming-Monitor im Portfolio. Der 24,1 Zoll große Monitor verfügt über ein 600 Hz schnelles TN-Panel und spricht damit vor allem E-Sport-Profis an.